本文作者:谷小露

随着AI技术的不断发展,大众对其的关注度也越来越高。

如今在招聘领域,有一项技术声称可以通过AI技术在视频面试过程中识别候选人的面部表情,从而判断其在面试过程中的情绪与状态,获得了不少市场关注。

不少HR关心,采用这项技术是否真的可以代替面试官对候选人进行面试?

2019年7月,5位分别来自美国东北大学、加州理工学院、格拉斯哥大学、俄亥俄州立大学和威斯康辛大学麦迪逊分校的顶级心理科学、神经科学和计算机科学领域的专家组成一个研究小组(2019年专家小组),在 《公共利益心理科学》(Psychological Science in the Public Interest)杂志上发表了他们的最新成果,对“微表情识别技术”背后的科学依据提出质疑。

这个研究被称为迄今为止微表情识别领域最大规模的荟萃分析(meta study)。

专家小组以“愤怒、厌恶、恐惧、开心、悲伤和惊讶”这六组常见情绪类别为对象,搜集并系统梳理了所有相关科学依据,以验证“通过一个人的面部肌肉动作可以推断出TA的情绪状态”这一常见的观点。

在这个过程中,专家小组试图验证“独特的面部肌肉动作模式指向单一情绪类别,且该特定面部肌肉动作模式的指向性充分具备可靠性和明确性。”这一结论。

但是,专家小组搜集归纳总结了关于人类表情产生的证据以及通过面部肌肉动作所推断情绪的证据之后发现,现有的推断“面部肌肉动作”与“情绪状态”两者有因果关系的科学研究存在以下三大缺陷:

1)不可靠:无法确定从同一组面部动作观察到相同情绪种类

2)缺乏明确性:无法找到单一面部肌肉动作与特定情绪类别存在独特关联性

3)有限普适性:场景和文化的作用未得到充分记录和归因

专家小组指出:人们虽然有时通过面部肌肉动作来表达情绪,但是人类表达情绪的方式受到文化、场景的影响而存在显著差异,即使是同一场景下,不同的人也存在不同表达方式;而且,相似的面部肌肉动作模式可同时表达多种情绪,即使是单一面部肌肉动作模式有时也能表达多种情绪。

经过对1000多项关于面部运动和情绪的研究进行综合分析,研究小组得出的结论是:

“几乎没有证据表明,仅通过一系列面部动作,就能准确推断出别人的情绪状态。”、“目前很多科技公司这方面技术的投入,实际上是在识别面部肌肉动作,而非情绪。”[1]

人的面部表情远远比机器所能识别出的含义更为复杂,将“AI微表情识别”这项技术用于面试是不可靠的。

之所以不可靠,其背后有诸多原因,下面带来详细分析。

一. 面部肌肉动作与情绪并非一一对应

心理学家和科学家对于面部肌肉动作和对应情绪的关系的研究由来已久,其中一种常见的普遍性认知因为刻板印象而具有误导性。

比如,俄勒冈大学的心理学家Azim F. Shariff和英属哥伦比亚大学心理学家 Jessica L. Tracy为了研究每个单一情绪类别所对应的面部结构,选取来九种不同的情绪表现来研究面部肌肉动作和情绪的关系。

研究基于的假设是每种情感类型都可以以独特的面部动作形态表现出来,(如怒容表明愤怒的存在,具有很高的可靠性和特异性)。这个假设本身带有经验主义的刻板印象,并未得到证实。

图1:九种不同面部肌肉动作对应的情绪特征

所以,尽管有一定的可靠性和特异性,但“微笑就能说明一个人开心”,“怒容就表示一个人愤怒”吗?

2019专家小组指出,特定面部肌肉动作是否表达特定情绪的成立取决于反向结论是否成立。

比如针对 “微笑说明一个人开心”这个结论,心理学家需要考察这个结论的反向推论(reverse inference) “开心的时候人就会微笑” 是否成立。

而反向结论成立需要满足心理学界公认的四元素标准:可靠性、明确具体性、普适性、有效性。只有当一个面部肌肉动作完全满足这个四个条件时才能称之为“情绪表情”。

图2:以愤怒和担心为例,定义可靠性和明确具体性

2019专家小组表示,由皱眉、咧嘴唇来定义一个人愤怒的可靠性和明确具体性时,往往会得出不同的结论。

在很多情况下,如果观察到一个人愤怒的时候不皱眉,就是对可靠性作出的无效假设(null hypothesis)。如果一个人在生气的时候偶尔皱眉,而且在恐惧、悲伤、困惑、饥饿等时候,更频繁地皱眉,那就需要对这种无效假设做近一步调研。

所以说,皱眉可能是愤怒的一种,而愤怒不一定会皱眉。

从有限的普适性来看,不同场景和文化的作用下,面部肌肉动作和情绪的关联未得到充分记录和归因。

一个人的大脑会受到其他因果因素的影响,而不是将研究结果与随机预期的结果进行对比。

比如说一个人可能会受到环境(家庭,公司,学校)和社会因素的影响(谁在场,情绪的接收者是谁),一个人的身体情况(睡眠是否充足,饥饿感),过去的经历以及个体的差异性等。由于偶然性的影响,许多专家在解释情绪和面部肌肉动作的关联时提出的必要非充分的证据。

另外,不同文化的人在表达某一情绪时也可能有不同表现。一个人的性别、种族、受教育程度都会影响一个人情绪表达的方式。

2017年,格拉斯哥大学的研究人员Rachael E Jack和Philippe G Schyns提出了更具科学性的“反向关联”(reverse correlation)方法,研究个体对面部动作对应情绪的判断。

他们让参与者根据计算机随机生成的面部动作单元(Action Units)任意在一系列情感词当中选择一个当做标签,然后对每个参与者选择的相同情绪词 (例如:愤怒) 标签的所有面部动作进行统计。

2018年,俄亥俄州立大学电子与计算机工程教授Aleix M. Martinez及其同事Ramprakash Srinivasan根据参与者所使用的语种进行他们进行分组,在五个语种组进行“反向关联”实验:要满足科学界对唯一的标准,参与者的需要意见一致,达到70%到90%一致性,但是实验结果显示,参与者意见一致率远低于这个值(见图3)。

由此得出结论,参与人员对每种面部动作代表的情绪判断分歧较大,每一种面部动作被认为可能有多种对应的情绪。

图3:五个语种组面部动作对应的任意标签

来自美国东北大学的心理学教授Lisa Feldman Barrett指出:“就算在西方文化内部,人们也只有在大约30%的时间里,是通过皱眉表现生气。”另外70%的时候,皱眉可能只是因为TA在努力集中注意力、甚至可能只是因为看不清楚屏幕。

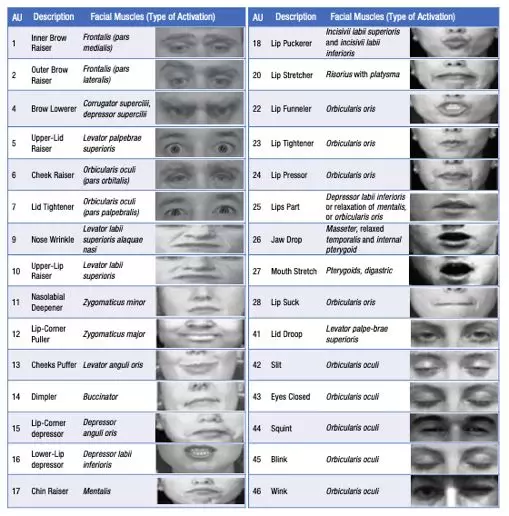

为了测试细微面部肌肉在不同情况下的变化,肌肉运动和情绪表达研究先驱美国加州大学心理学家Paul Ekman和他的两位同事Wallace V. Friesen及Joseph C. Hager在2002年发表了更新版的经典面部运动编码系统(FACS),对不同表情的面部肌肉进行识别。

发现虽然算法的准确率在理想情况下可以达到90%的正确率,但是受到不同表情数据库的影响,加上所有的照片都是选择的理想化状态,会对实验结果产生影响,导致正确率会有差异。

由此发现,人的面部肌肉动作即使在理想情况下也无法被编码系统准确判断。[2]

图4:运用经典的面部运动编码系统(Facial Action Coding System)对面部肌肉动作进行分析

另外,人为因素的干扰也导致数据准确率问题,如当科学家在分析面部肌肉动作和情绪的关联时往往会受到参与者和其他观察者的影响以及科学家自己(使用各种标准,包括常识推断)的判断而忽视很多不可控的因素。

比如,神经系统引起的心血管、呼吸系统或排汗系统的变化以及中枢神经系统的动态变化如血液流动、脑电活动等与表情解读人无关的(perceiver independent)因素。它们是导致人在特殊情况下的情绪变化产生不确定的因素。

为了验证各个情绪对应的面部肌肉动作,马德里自治大学的研究员Duran, J. I. ,格赖夫斯瓦尔德大学Reisenzein, R. 和 Fernández-Dols, J.-M.在2017年进行了个体对情绪反映词的测试。

当参与者被给予一个简单的情绪词或一个简短的陈述来描述每个情绪类别,然后被要求自由地摆出他们认为自己在表达情绪时做出的面部表情,发现:不同的人在面对相同的词时反应往往不同。

这种差异一方面是因为意志性和非意志性面部运动是由不同的神经回路控制的;另一方面,人们对表情反应的意志性控制往往反映了他们对某种情绪的刻板印象,他们在现实生活中出现这种情绪时,并不一定是如此表现。

图5:情绪测试中的面部肌肉动作识别

以上的研究可以得出的结论是,人的面部肌肉动作和人的心理特征并不存在严格的一一对应,就像在日常交往中,我们都知道人不可能完全通过微笑判断对方是否开心,通过皱眉判断对方是否悲伤。

人在交谈中,可以通过对方的其他表现(语气、肢体动作等)来辅助判断,但即使这样,都未必能感知到对方真正的情绪,更不要说那些只“阅读面部表情“的机器了。

如果想要让机器进行多方面的识别,对于现阶段还未成熟的技术来说,难度又过高了。

二. AI微表情识别容易造成数据集偏差

很多人想当然地认为,相比较由真实的“人”来做面试官,“客观”的AI能够减少面试官在面试时对诸如口音、外貌和性别等方面的主观偏见。

但是,有很多业内人士都对此观点提出了质疑与辩驳。

纽约大学 AI Now 研究所主任和微软研究所首席研究员Kate Crawford认为,通过算法来识别面部表情和情感,反有可能将大众带入更多误区。

纽约大学 AI Now 研究所2019年年度报告中称:“通过解读面部微表情来读取内在情绪,这一技术缺乏严谨扎实的科学依据,目前的科学研究尚不足以保证识别结果的准确性和有效性。”

研究显示,表情识别的算法模型并未经过学界严谨的同行评审,无法评估这些模型是否运作、如何运作,更无法判断其是否有效运作。[3]

加州大学伯克利分校的心理学研究员Zhimin Chen和心理学、视觉科学和神经科学研究员David Whitney在2019年2月的研究报告中指出,要探知准确探知情绪,并且达到高度一致性的判断,需要脸和肢体以外的情景信息。[4]

伦敦大学人机交互教授 Anna Cox 则表示,任何数据集都存在偏差,算法会更青睐那些擅长情绪外露的人,从而可能错过那些内向但在实际工作中表现优秀的人。[5]

如今有越来越多的企业借AI面试做宣传。

《大数据文摘》在调研AI面试的影响认为:大范围启用“AI面试”的成因以及前提是,招聘岗位大多没有专业限制的情况下,由于品牌效应众多候选人趋之若鹜,以致HR简历筛选压力非常大;另一方面,有部分雇主认为这是一次宣传雇主品牌的好机会,通过“酷炫”的面试技术,可以在追求新鲜的年轻人中打响公司名声。[6]

杜克大学的经济学教授 Emma Rasiel 表示,AI面试这种与计算机屏幕交流的模式与难以理解的“未知算法”迫使求职者面对一种新的面试焦虑。

面试官在面试过程中的提问、反馈、建议以及谈吐、行为,是候选人面试体验中非常重要的一环。

而在AI面试中,“面试官”这一角色的缺失,确实对候选人体验造成的了潜在的负面影响,甚至会错失优秀的候选人。

对于很多科技公司在读取面部表情的研发设备的投入,2019专家小组的结论是:“目前很多科技公司这方面技术的投入,实际上是在识别面部肌肉动作,而非情绪。”

如果向仅通过识别面部运动来简单“读出”人们的内部状态,并且完全不考虑其他因素,无论多么复杂的算法,都是不完整的。这种做法仅仅是基于普遍的观点,缺乏科学依据。

由于情绪表达比通常认为的更多变,而且更依赖于不同的情境,不宜将面部肌肉动作作为判断个人情绪可靠的、明确具体的证据。

专家小组表示,AI面试的技术本身仍然有很大的进步和升级空间,但在这项技术暂未得到科学认可与权威认证的情况之下,不宜迷信或神话这项技术,需要直面技术存在的问题与隐患。

对于企业与招聘者来说,在充分认识到技术的便利与风险的基础上,理性、慎重、结合自身实际地选择恰当的面试方式,才是正确的做法。

[1]Barrent L.F.,Adolphs R., Barrett, L. F., Adolphs, R., Marsella, S., Martinez, A. M., & Pollak, S. D. (2019).《Emotional Expressions2019》* 研究基金来源包括美国陆军研究所行为、社会科学基金、美国国家癌症研究所基金、美国国家自然科学基金。

[2] Ekman, P., Friesen, W. V., & Hager, J. C. (2002). Facial Action Coding System: The manual on CD ROM. Salt Lake City, UT: The Human Face.

[3]AI Now, 2019 Report,2019,New York University

[4]Zhimin Chen and David Whitney, “Tracking the Affective State of Unseen Persons,” Proceedings of the National Academy of Sciences, February 5, 2019,

[5]https://www.ucl.ac.uk/news/headlines/2019/sep/artificial-intelligence-analysing-interview-candidates

[6]大数据文摘,《无接触招聘季,准备好迎接AI面试官的暴击了吗?》2020-03-04,https://www.huxiu.com/article/342777.html

注:未经许可请勿转载